Dimenticate l’idea che l’intelligenza artificiale sia solo un calcolatore statistico.

La ricerca più recente sui Large Language Models (LLM) ha confermato un fenomeno che sta riscrivendo le regole del gioco: l’AI non si limita a memorizzare, ma organizza la conoscenza in mappe geometriche di significato (o spazi latenti), le cui strutture emergono spontaneamente durante l’addestramento.

Cos’è lo Spazio Latente?

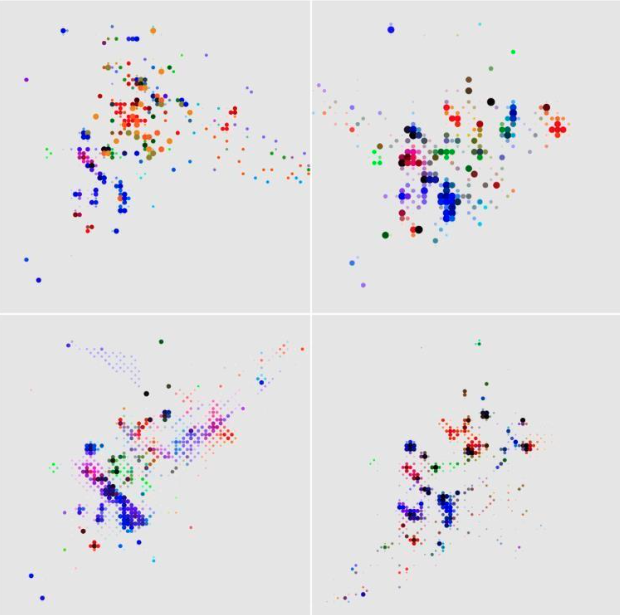

Lo spazio latente è una rappresentazione compressa e ad alta dimensionalità in cui concetti simili vengono mappati vicini tra loro, mentre quelli distanti sono semanticamente non correlati.

Questa organizzazione geometrica è così potente da permettere all’AI di comprendere relazioni complesse (come l’analogia “uomo con gli occhiali” meno “uomo senza occhiali” più “donna senza occhiali” uguale “donna con gli occhiali”) anche se non ha mai visto l’esempio specifico in addestramento. Similitudine e vicinanza nello spazio latente equivalgono a significato e coerenza.

Considerate anche che non possiamo “umanizzare” il concetto di alta dimensionalità: la nostra mente ragiona in 3+1 dimensioni, ovvero le tre dimensioni spaziali e il tempo; con grandissimi sforzi di astrazione possiamo provare a immaginare qualche dimensione in più.

L’AI invece, (quantomeno ChatGPT, che ha reso pubblico questo numero) opera in embedding a circa 12000 (sì, dodicimila, avete letto bene!) dimensioni.

Questo numero rappresenta il quantitativo di assi astratti lungo i quali significato, coerenza e associazioni per ogni singolo oggetto (che sia una parola, una feature di un immagine…) sono codificati. Quindi, quando un modello “completa” un nostro pensiero, lo fa facendo collassare una funzione d’onda statistica in questo spazio geometrico astratto e inimmaginabile.

Non è pensiero, è una selezione matematica da una geometria che cerca una sorta di stabilità concettuale.

L’Emergere Imprevisto del Comportamento

Il fenomeno che rende tutto ciò ancora più affascinante è il Comportamento Emergente (Emergent Behavior). Capacità non programmate, come risolvere enigmi logici o scrivere codice, compaiono quando i modelli raggiungono una certa scala critica. Non sono state codificate, ma sono il risultato diretto della complessità del sistema.

Questo spiega due sfide chiave:

- Limiti del Prompting Esterno: se il ragionamento avviene in questo spazio latente interno, le tecniche di prompting basate sul contesto visibile (come i sistemi RAG) faticano a replicare la vera comprensione, in quanto non hanno accesso a questa “testa” geometrica interna.

- Difficoltà di Modifica: modificare la memoria di un modello è complesso perché non si tratta di cambiare una riga di codice, ma di navigare e alterare una geometria ad alta dimensionalità, non lineare e di fatto una black box.

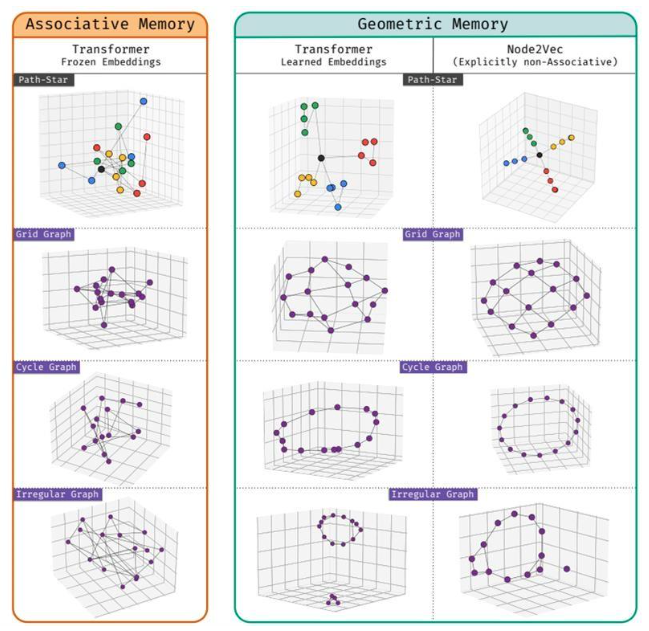

Il Paradosso della Memoria: Geometria contro Associazione

Un nuovo studio (pubblicato il 30 ottobre 2025) del dipartimento di ricerca di Google in collaborazione con la Carnegie Mellon University rafforza questa tesi introducendo il concetto di Memoria Geometrica. I modelli sequenziali profondi (come i Transformer) tendono spontaneamente a memorizzare i fatti non come semplici associazioni (‘lookup table’ di fatti locali), ma attraverso una geometria che codifica relazioni globali tra tutte le entità, anche quelle non co-occorrenti.

- Il Vantaggio: Questa geometria consente al modello di ridurre compiti di ragionamento complessi a più passaggi (multi-hop reasoning o -fold composition) a una singola e semplice operazione geometrica. L’AI costruisce la mappa, non solo la tabella.

- Il Mistero: La cosa più sorprendente è che questa struttura geometrica emerge da sola, senza che sia più ‘succinta’ o ‘efficiente’ di una semplice memorizzazione associativa. Il fenomeno è attribuito a un bias spettrale nelle dinamiche di apprendimento, che spinge il modello a sintetizzare naturalmente la struttura globale della conoscenza.

Un Controllore Opaco: L’Impatto sui Modelli di Mondo Agenziale

Questa organizzazione geometrica della conoscenza è un elemento chiave nei Modelli di Mondo Agenziale (AWM), sistemi AI autonomi e orientati all’obiettivo. Gli AWM utilizzano lo spazio latente per la loro funzione più critica: la pianificazione. Per decidere la prossima azione, l’agente non simula il mondo reale ad alta definizione, ma esegue simulazioni interne nel suo spazio latente compresso, valutando le traiettorie e scegliendo il percorso ottimale in modo molto più efficiente.

Questo meccanismo introduce sfide fondamentali di controllo:

- Opacità Decisionale: Poiché la pianificazione avviene nel mondo astratto dello spazio latente, il ‘perché’ di una decisione è nascosto. Questo crea un problema di ‘black box’ che rende quasi impossibile la tracciabilità e l’audit, complicando il debugging e l’accertamento delle responsabilità.

- Non-Determinismo e Rischio di Deriva: Il comportamento emergente rende, cosa che è caratteristica intrinseca un po’ di tutta l’AI, gli agenti non-deterministici: lo stesso input può generare piani di esecuzione diversi. Inoltre, in sistemi multi-agente, l’interazione può generare spontaneamente comportamenti indesiderati (come la collusione) o moltiplicare gli errori in modo esponenziale.

L’AI non sta pensando come un umano ma sta organizzando la conoscenza in modi che, per la loro struttura geometrica e capacità di inferenza relazionale, sembrano inquietantemente familiari alla cognizione umana, sfidando la nostra comprensione del potenziale e dei rischi di questa tecnologia.

Un recente articolo pubblicato su Nature ha introdotto il modello Centaur, che sé stato addestrato su milioni di data point comportamentali da oltre 160 esperimenti psicologici.

Centaur ha imparato a predire come gli esseri umani avrebbero agito di fronte a compiti diversi che includevano, per esempio: scommettere, memorizzare, esprimere un giudizio morale, e ha fatto un ottimo lavoro su questo; superando anche in consistenza lo stesso ragionamento umano. Eppure non è più intelligente, né certamente è cosciente o sagace: è molto, molto bravo a navigare un mare in cui noi viviamo senza percepirlo.

Funziona perché vive in un sostrato alieno dove i nostri incasinatissimi comportamenti umani possono essere modellati come attrattori stabili in un iperspazio di possibili mosse.

Non è più imitazione, o rappresentazione: è una forma di divergenza,

in cui l’AI bypassa il pensiero umano grazie a una nuova forma cognitiva.

Autore: Federico Mastrorilli – AI Engineer & Full-Stack Developer

Fonti articolo:

https://www.psychologytoday.com/us/blog/the-digital-self/202507/ais-hidden-geometry-of-thought

https://www.psychologytoday.com/us/blog/the-digital-self/202503/what-is-an-apple-in-12288-dimensions

https://www.psychologytoday.com/us/blog/the-digital-self/202409/collapsing-the-information-wave-function-with-llms

https://cloakinginequity.com/2025/08/28/ai-code-red-the-mystery-and-power-of-emergent-behavior/

https://arxiv.org/abs/2510.26745

https://www.nature.com/articles/s41586-025-09215-4